- Как работают поисковые системы: принципы, алгоритмы, история развития

- Что такое поисковая система

- Краткая история поисковых систем

- Как работает поисковая система Гугл

- Как поисковики сканируют сайты

- Почему вашего сайта может не быть в выдаче

- Как работает поисковик при распознавании сайта: индексирование

- Как поисковик присваивает место в выдаче

- Как работают поисковые системы.

- Шаг 1: Сканирование.

- Зачем нужно заботиться о процессе сканирования?

- Как узнать, сколько страниц вашего сайта включено в индекс Яндекс и Google?

- Шаг 3: Ранжирование

- Как работают алгоритмы поисковых систем?

- 1й этап: Анализ пользовательского запроса

- 2й этап: Поиск подходящих страниц

- Как работают алгоритмы гугл. Выясняем, что такое сканирование поисковыми системами

- Что такое индекс поисковой системы

- Рейтинг в поисковых системах. Как происходит Индексация сайта в Google?

- Как работает поисковая система?

- Сканирование

- Индексирование

- Основные функции поисковой системы

- Сканирование

- Индексирование

- Ранжирование

- Человек как помощник в борьбе за качество выдачи

- Заключение

- Принципы работы поисковой системы

- Сбор данных

- Индексация

- Обработка информации

- Ранжирование

- Основные характеристики поисковых систем

- Полнота

- Точность

- Актуальность

- Скорость поиска

- Наглядность

- Выводы

Компания BackRub была основана в 1996 году. Его главное преимущество заключается в том, что он индексирует глобально. В 1998 году она была переименована в Google. И сегодня это самый популярный в мире сервис для поиска информации в интернете (по данным аналитиков, им пользуются около 85% всех пользователей интернета).

Как работают поисковые системы: принципы, алгоритмы, история развития

Поисковые системы помогают пользователям находить информацию в Интернете. Все, что вам нужно сделать, это зайти на страницу поисковой системы, ввести свой вопрос и вуаля — система предоставит вам сотни ссылок на страницы, где вы сможете найти ответы на свои вопросы. На первый взгляд это кажется простым, но на самом деле это работа миллионов устройств и тысяч людей.

В этой статье мы объясним простым языком, что такое поисковые системы, как они работают, есть ли конкуренты у гигантов Google и Yandex и каковы перспективы рынка поисковых систем.

- Бюджет в 3 000 евро гораздо дешевле, чем работать напрямую.

- Для компаний и физических лиц — компании могут получить закрывающие документы и возмещение НДС. Частные лица могут разместить объявление без необходимости иметь дело с администраторами.

- 3 способа оплаты — оплата рекламы кредитной картой, расчетным счетом компании, электронными деньгами.

Что такое поисковая система

Поисковая система — это веб-ресурс (веб-сайт и/или приложение), который представляет собой каталог других веб-сайтов.

Поисковые системы можно использовать для поиска страниц, документов, изображений, аудио- или видеофайлов, которые содержат ключевые слова (или слова, связанные с этими ключевыми словами), указанные в запросе. Для выполнения этой задачи алгоритмы анализируют миллиарды страниц в секунду и выдают список результатов. Это не случайно — позиция каждого сайта определяется алгоритмами поисковых систем.

Абсолютная мечта каждого владельца сайта — как можно чаще попадать в топ, а еще лучше — на первое место в списке.

Краткая история поисковых систем

Сейчас основные поисковые системы (особенно Google и Яндекс) представляют собой целый комплекс сервисов и инструментов и создают собственные экосистемы — это сам поиск, инструменты для создания рекламы, дополнительные сервисы для бизнеса (Google Мой бизнес, Яндекс. Бизнес), инструменты для обычных пользователей (Яндекс.Район, Яндекс.Такси, Яндекс Дзен, переводчики Google и Яндекс), собственные платежные системы (Google Pay, Яндекс Pay), новости Google и Яндекс, карты для навигации, голосовой поиск и голосовые помощники (например, Алиса от Яндекс) и многое другое.

Давайте посмотрим, с чего все началось.

Как первоначально появились поисковые системы? Хронология:

— До появления первых поисковых систем ссылки на сайты передавались из рук в руки и хранились в текстовых файлах,

— Позже были созданы каталоги, в которые вручную вносились адреса сайтов и распределялись по категориям. Однако в этих каталогах еще не было поисковых запросов,

— В 1989 году (по некоторым данным в 1990 году) появился «предок» всех поисковых систем — система Archie (Archie как архив, но без буквы v). Archie представлял собой загружаемый и доступный для поиска архив со списками существующих файлов и каталогов, но еще не индексировал содержимое этих файлов,

— После Арчи появились две другие фигурки, Вероника и Джагхед, которые работали аналогичным образом,

— до 1993 года, когда было создано еще несколько справочников, которые заполнялись вручную. Опять же, полной индексации не было,

— В 1993 году появилась первая World Wide Web Wanderer — поисковая система, которая собирала URL-адреса и подавала их в единую базу данных Wandex,

— В том же 1993 году на базе World Wide Web Wanderer был создан Aliweb — первая поисковая система, но она еще не использовала автоматических роботов. Для того чтобы сайты индексировались и находились в поиске, их владельцы должны были вручную вводить адреса в Aliweb. Кроме того, их сайты должны были иметь специальный индексный файл, который распознавался поисковой системой Aliweb,

— В период с 1993 по 1996 год было разработано множество других простых поисковых систем. JumpStation, например, использовал поискового робота и включал форму для ввода поисковых запросов, но поиск был ограничен только заголовками страниц. Однако с помощью WebCrawler можно было искать не только по названиям, но и по словам веб-страниц, и этот принцип лег в основу современных поисковых систем. Из всех этих систем сегодня существует только Yahoo,

— В 1993 году появился Яндекс (разработка компании CompTek, основанной Аркадием Воложем), на тот момент еще не полноценный веб-поисковик, а поисковая система по информации и файлам на жестком диске компьютера. Кстати, в аналитике слово Яндекс означает «еще один индексатор» (Yet ANother inDEXer). Чтобы программа работала, компания CompTek создала специальный русский словарь для поиска по ключевым словам. В 1995 году было принято решение усовершенствовать программу для поиска в Интернете (в основном в русскоязычной части). Сначала «Яндекс» работал с ограниченным количеством сайтов, а позже начал осуществлять поиск по всему Рунету. Яндекс.Ру был официально объявлен в 1997 году,

Как работает поисковая система Гугл

Основные принципы и функции этой поисковой системы:

Google Search извлекает информацию из веб-страниц, медиафайлов, отсканированных документов, общедоступных баз данных, содержимого, добавленного в службы Google (например, Google Мой бизнес и Google Maps), и других источников.

Весь процесс поиска и извлечения информации можно разделить на 3 основных этапа:

- Сканирование страниц и файлов. Во-первых, Google собирает информацию путем поиска новых страниц и добавления их в свою базу данных. Это делает специальный робот — Googlebot. Некоторые из этих роботов выполняют поиск на сайте, другие индексируют изображения, а третьи сканируют страницы и файлы для мобильных устройств. Роботы могут определять оригинальные страницы, копии, обычные страницы и их дубликаты.

Google может найти ссылку на ваш сайт на других сайтах; вы также можете запросить ручное сканирование вашего сайта и использовать веб-сайт. Роботы решают, какие сайты просматривать, сколько страниц и как часто.

P.S. Если страница доступна с разных URL или если есть схожее содержание, например, для мобильной версии и версии для настольных компьютеров, поисковая система группирует возвращающиеся URL с (обычной) главной страницей, которая индексируется чаще других, и ее дубликатами.

- Индексирование. Роботы обрабатывают содержимое каждой страницы — текст, медиафайлы, теги (title, description), атрибуты для изображений (title, alt). Вы можете защитить страницу от индексации, используя теги «nofollow» или «noindex» или написав рекомендации в файле Robots.txt.

Чтобы ускорить индексацию сайта в Google, необходимо добавить его в Google Search Console и Google Analytics.

P.S. В 2020 году Google Webmaster будет переименован в Google Search Center.

- Передача результатов поиска. Алгоритмы (которые постоянно меняются и совершенствуются) предоставляют пользователю результаты, которые наилучшим образом соответствуют его поисковым запросам на основе уже собранной информации. На этот процесс влияют сотни факторов, в том числе: Поведенческие факторы, скорость загрузки страницы, мобильная оптимизация, уникальность контента, удобство навигации по странице, местоположение, достоверность страницы и дизайн.

Результат предоставляется в виде страниц со ссылками на веб-сайты, изображений, новостей, инфографики и видео.

Для обеспечения правильного вывода были разработаны специальные алгоритмы. Нет смысла пытаться адаптировать свой сайт к каждому алгоритму по мере работы над ними, ежедневно тестируя и экспериментируя (по словам разработчиков).

По сути, алгоритмы отвечают за следующее:

Анализ слов и фраз — определение значения слов, поиск орфографических ошибок в запросе, вычисление коллоквиализмов. Он также учитывает тип запроса (ищет ли человек обзор, новости или видео) и релевантность информации.

Пример: Мы ищем слово «утренние славы». Google автоматически определяет, что запрос, вероятно, составлен неправильно и что мы ищем информацию о рэпере Morganstern. Он показывает исправленную версию и предоставляет информацию об этом человеке — сначала видео, биографию и сайты, на которых доступна его музыка, а затем статьи (поскольку Моргенштерн — артист, пользователь, вероятно, ищет его музыку и песни, а также видео).

Прежде всего, важно понимать, что поисковые системы — это коммерческие организации. Их цель — получение прибыли. Можно получить прибыль от контекстной рекламы, от других видов рекламы, от продвижения нужных сайтов на верхних производственных линиях. В общем, существует множество возможностей.

Как поисковики сканируют сайты

Поисковые системы посылают своих роботов на каждый сайт в поисках нового и обновленного контента. Сканируется не только текст, но и изображения, видео, таблицы и вложения. Роботы просматривают все страницы и переходят по всем внутренним ссылкам.

Однако роботы поисковых систем не могут использовать формы поиска на сайтах — если вы не сделаете внутреннюю ссылку на сайт, роботы не включат все страницы в выдачу сайта. Информация о новых веб-сайтах или обновлениях существующих веб-сайтов собирается и используется для обновления индекса Google.

Почему вашего сайта может не быть в выдаче

- сайт новый, и поисковая система еще не успела его просканировать

- на сайте сложная навигация, поэтому он дольше загружается роботами

- сайт был внесен в черный список за рассылку спама

- сайт был заблокирован для посещения роботами

- сайт не содержит ссылок с других сайтов

Как работает поисковик при распознавании сайта: индексирование

Чтобы ваш сайт попал в SERP, одного сканирования недостаточно. Сайт должен быть проиндексирован. Отсканированные и обработанные страницы должны храниться в специальной базе данных. Эта база данных называется «поисковым индексом».

Если сайт проиндексирован, это означает, что поисковая система уже изучила, оценила и сохранила его. Теперь он может отображать ее в результатах по соответствующим поисковым запросам.

Чтобы проверить, проиндексирован ли ваш сайт, перейдите на страницу поисковой системы и наберите в поисковой строке «site:your_site.com». Количество результатов поиска указывает на количество проиндексированных страниц на вашем сайте.

Если вы хотите проиндексировать новый сайт, вам необходимо сделать следующее:

- Создайте карту сайта и сделайте ссылку на нее в файле robots.txt.

- Добавьте свой сайт в Яндекс.Вебмастер

- Установите счетчик Яндекс.Метрики.

- Сделайте запрос на индексацию страницы в Search Console.

Файлы robots.txt располагаются в корневом каталоге сайта. Они содержат информацию для поисковых машин — с какой скоростью поисковые машины будут просматривать сайт или какие страницы они оставят нетронутыми. В настройках панели управления убедитесь, что функция «Видимость для поисковых систем» не заблокирована. В противном случае поисковые системы не смогут получить доступ к вашему сайту через файл robots.txt.

Как поисковик присваивает место в выдаче

Ранжирование — это процесс ранжирования веб-сайтов в соответствии с их релевантностью поисковому запросу пользователя. Поисковые системы разрабатывают собственные алгоритмы ранжирования. За последние годы они несколько раз менялись. Google, например, ежедневно вносит коррективы в свой алгоритм для улучшения качества поиска.

Основные принципы ранжирования поисковых систем заключаются в том, чтобы обеспечить размещение наиболее релевантных данных выше в результатах. Актуальность, как правило, зависит от нескольких факторов. Для многих поисковых систем окончательная функция релевантности представляет собой комбинацию небольшого количества факторов — 5-15 штук. Ряд составных факторов используется независимо в качестве отдельной функции ранжирования.

Для обеспечения правильного вывода были разработаны специальные алгоритмы. Нет смысла пытаться адаптировать свой сайт к каждому алгоритму по мере работы над ними, ежедневно тестируя и экспериментируя (по словам разработчиков).

Как работают поисковые системы.

Поисковые системы — это сложные компьютерные программы.

Прежде чем ввести поисковый запрос и искать в Интернете, они должны проделать большую подготовительную работу, чтобы при нажатии кнопки «Поиск» вы получили набор точных и качественных результатов, отвечающих на ваш вопрос или запрос.

Что включает в себя «подготовительная работа»? Два основных этапа. Первый этап — это процесс поиска информации, а второй этап — организация информации таким образом, чтобы ее можно было в дальнейшем использовать в целях поиска.

В мире Интернета эти этапы известны как сканирование (или ползание) и индексирование.

Шаг 1: Сканирование.

Поисковые системы имеют набор компьютерных программ, называемых поисковыми роботами (или веб-пауками, веб-краулерами), которые отвечают за поиск информации, доступной в Интернете.

Чтобы упростить сложный процесс, достаточно знать, что работа этих роботов заключается в поиске в Интернете серверов, также называемых веб-серверами, на которых размещаются веб-сайты.

Поисковые роботы составляют список всех веб-серверов, которые необходимо проверить, определяют количество веб-сайтов, размещенных на каждом сервере, и затем приступают к работе.

Они посещают каждый сайт и с помощью различных методов пытаются подсчитать, сколько на нем страниц с различным содержанием, таким как текст, изображения, видео или другие форматы (CSS, HTML, Javascript и т.д.).

Зачем нужно заботиться о процессе сканирования?

При оптимизации сайта для поисковых систем необходимо, прежде всего, убедиться, что поисковые системы могут получить доступ к сайту должным образом. Если они не могут «прочитать» ваш сайт, не стоит ожидать хорошего рейтинга в поисковых системах.

У сканеров много работы, и вы должны постараться облегчить им работу.

Есть несколько вещей, которые вы должны сделать, чтобы облегчить программному обеспечению поиск и доступ к вашему сайту.

Используйте файл Robots.txt, чтобы указать, какие страницы вашего сайта не должны попадать в поиск. Эти страницы включают различные служебные страницы, такие как центр управления сайтом, и некоторые другие страницы, которые по разным причинам не должны включаться в результаты поиска.

Крупные поисковые системы, такие как Яндекс и Google, имеют инструменты (также называемые инструментами для веб-мастеров), которые вы можете использовать, чтобы предоставить им больше информации о вашем сайте (количество страниц, структура и т.д.). Тогда поисковым машинам не придется самим просматривать ваш сайт.

Используйте XML sitemap, чтобы перечислить все важные страницы вашего сайта. Тогда поисковые системы будут знать, на какие страницы обращать внимание, а какие игнорировать.

Когда они посещают ваш сайт, они не только считают количество страниц, но и нажимают на каждую ссылку (независимо от того, ведут ли они на страницы вашего сайта или на внешние сайты) и таким образом открывают для себя все новые и новые страницы.

Поисковые системы делают это постоянно, а также отслеживают изменения на сайте, чтобы узнать, когда добавляются или удаляются новые страницы, когда обновляются ссылки и другую подобную информацию.

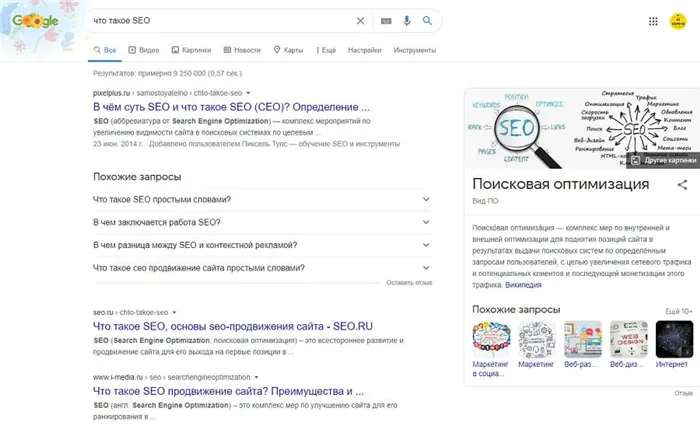

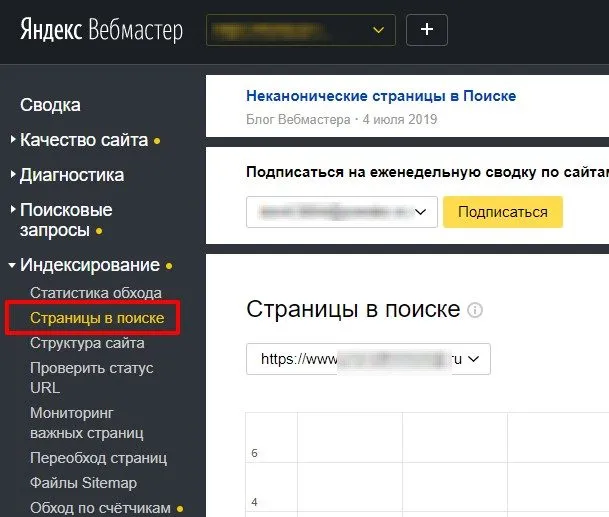

Как узнать, сколько страниц вашего сайта включено в индекс Яндекс и Google?

Это можно сделать двумя способами.

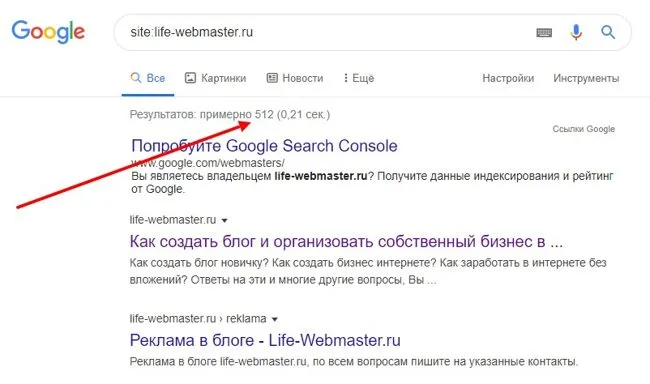

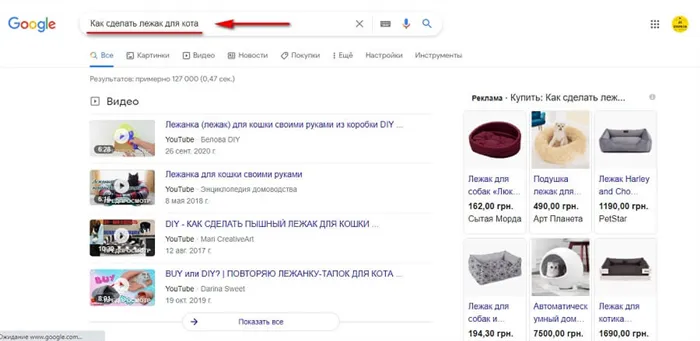

Откройте Google и используйте оператор сайта, затем введите двоеточие «:», а затем имя вашего домена. Это покажет вам, сколько и какие страницы проиндексированы поисковой системой.

Вот как это выглядит в Google:

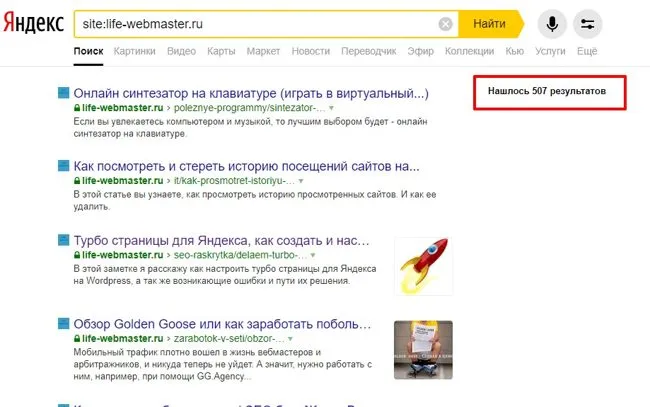

А вот как это выглядит в Яндекс:

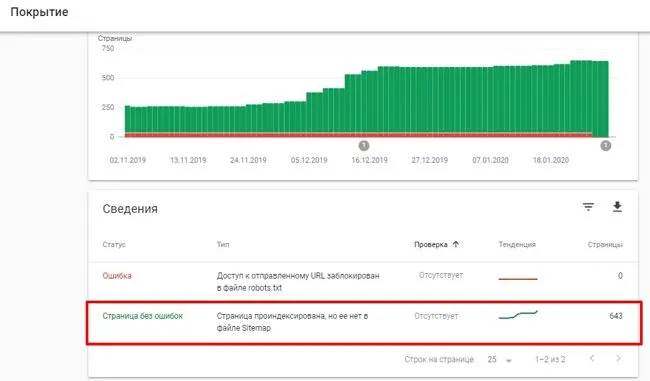

Добавьте свой сайт в Google Search Console, подождите несколько дней, пока поисковая система обработает ваш сайт, а затем вы сможете увидеть отчет о достижении и особенно информацию о проиндексированных страницах.

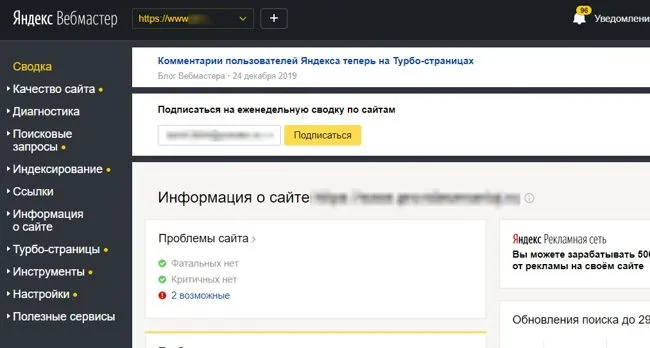

В Яндекс Вебмастере вы также можете посмотреть, какие страницы проиндексированы поисковой системой Яндекс.

Шаг 3: Ранжирование

На третьем и последнем этапе поисковые системы решают, какие страницы появляются в результатах поиска и в каком порядке, когда пользователь вводит свой запрос.

Это достигается благодаря использованию алгоритмов размещения поисковых систем. Проще говоря, это алгоритм, по которому работает программное обеспечение поисковой системы. Алгоритм определяет, какие страницы отвечают на поисковый запрос пользователя и в каком порядке они отображаются.

Как работают алгоритмы поисковых систем?

За прошедшие годы алгоритмы ранжирования поисковых систем сильно эволюционировали и стали очень сложными.

Вначале это было сравнение заголовков с поисковым запросом. Затем нужно было проанализировать текст. Этот текст, в котором частота слов, связанных с поисковым запросом, выходит на первое место в поиске.

Все это привело к тому, что веб-мастера начали заполнять страницы подобными поисковыми запросами и тем самым выходить на первые позиции. Проблема заключалась в том, что эти тексты не отличались высоким качеством для среднего пользователя. Часто эти тексты были нечитабельны.

В результате поисковые системы эволюционировали и теперь учитывают сотни различных параметров сайта.

Чтобы было проще понять, ниже приводится упрощенное представление факторов ранжирования поисковых систем:

1й этап: Анализ пользовательского запроса

Прежде всего, поисковые системы должны понять, какую информацию ищет пользователь. Для этого они анализируют поисковый запрос пользователя (условия поиска), разбивая его на ряд значимых ключевых слов.

Ключевое слово — это слово, которое имеет конкретное значение и цель.

Например, если вы набираете «how to make chocolate cake», поисковые системы по словам «how to make» понимают, что вы ищете инструкции по приготовлению шоколадного торта, и поэтому в результатах выдаются кулинарные сайты с рецептами.

Если вы делаете поиск «buy refurbished…», они знают, что вы хотите что-то купить, исходя из слов «buy» и «refurbished», и в результатах будут сайты электронной коммерции и интернет-магазины.

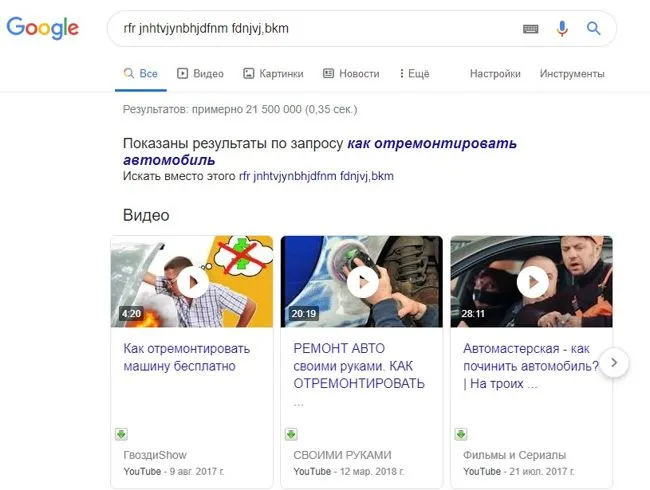

Используя машинное обучение, они смогли связать связанные ключевые слова. Например, они знают, что вопрос «How do I fix a phone» означает то же самое, что и «How do I repair a phone».

Они также достаточно интеллектуальны, чтобы понимать орфографические ошибки, произношение множественного и единственного числа, ударения и вообще извлекать смысл вопроса из естественного языка (письменного или устного в случае фонетического поиска).

Даже если посетитель ошибется в раскладке клавиатуры, поисковая система поймет это и выдаст нормальную выдачу.

2й этап: Поиск подходящих страниц

На втором этапе изучаются страницы индекса и принимается решение о том, какие страницы могут наилучшим образом ответить на запрос.

Это очень важный шаг во всем процессе, как для поисковых систем, так и для владельцев сайтов.

Поисковые системы должны как можно быстрее выдавать наилучшие результаты, чтобы удовлетворить своих пользователей, а владельцы сайтов хотят, чтобы их сайты занимали первые места в поисковых системах и привлекали больше посетителей.

Это также этап, на котором хорошие SEO-практики могут повлиять на решение алгоритмов.

Алгоритм, который составляет окончательный рейтинг сайтов по заданному поисковому запросу. Этот алгоритм выбирает ссылки, которые будут показаны пользователю, а также определяет, как они должны быть ранжированы от позиции 1 до позиции 10, 100 позиций.

Как работают алгоритмы гугл. Выясняем, что такое сканирование поисковыми системами

Сканирование — это процесс, с помощью которого поисковые системы выявляют обновленный контент в Интернете, например, новые сайты или страницы, изменения на сайтах и мертвые ссылки. Для этого поисковая система использует программу, называемую краулером, ботом или пауком (у каждой поисковой системы свой тип).

Он работает в соответствии с алгоритмом, определяющим, какие сайты и как часто просматриваются. Контент бывает разных форм — веб-страница, изображение, видео, PDF-файл и т.д. Независимо от формата, контент сканируется с помощью ссылок.

Сначала Googlebot загружает некоторые веб-страницы, а затем переходит по ссылкам на этих веб-страницах, чтобы найти новые URL-адреса. Проходя по пути ссылок, сканер находит релевантный контент и добавляет его в Caffeine Index — базу данных обнаруженных URL-адресов. Именно так обнаруживается новый контент.

Что такое индекс поисковой системы

Поисковые системы обрабатывают и хранят найденную информацию в индексе — базе данных контента. После того как поисковая система обрабатывает каждую страницу, которую она видит, она создает индекс видимых слов и их положение на каждой странице. По сути, это база данных, содержащая миллиарды веб-страниц.

Затем извлеченный контент сохраняется, информация систематизируется и интерпретируется алгоритмом поисковой системы для оценки важности в сравнении с аналогичными страницами.

Благодаря этим серверам пользователи могут получать доступ к веб-страницам за доли секунды. Для хранения и сортировки информации требуется много места, поэтому у Microsoft и Google более миллиона серверов.

Рейтинг в поисковых системах. Как происходит Индексация сайта в Google?

После ввода поискового запроса в поисковую строку система проверяет страницы в индексе, чтобы убедиться, что они соответствуют поисковому запросу. Эти страницы оцениваются на основе алгоритма, состоящего из сотен сигналов ранжирования.

Эти страницы (или изображения и видео) отображаются пользователю в соответствии с полученной оценкой.

Для того чтобы сайт находился на верхних строчках страниц результатов поисковых систем, необходимо убедиться, что поисковые системы правильно его индексируют. В противном случае они не смогут разместить содержимое сайта в результатах поиска.

- Типология сайтов: классификация, проводимая поисковой системой для отличия одного запроса от другого,

- Контекст,

- время,

- Макет: поисковая система отображает различные результаты в зависимости от цели поиска.

Помимо общих целей, могут быть и промежуточные цели: включение сайта в индекс или максимально возможная релевантность отдельных страниц сайта целевым поисковым запросам.

Как работает поисковая система?

Теперь перейдем к собственно работе поисковой системы. Он состоит как минимум из трех этапов:

- Сканирование,

- индексирование,

- рейтинг.

Количество веб-сайтов в Интернете просто астрономическое. И каждый сайт — это информация, информационный контент, созданный для читателей (живых людей).

p, blockquote 32,0,0,0,0 —>

Сканирование

Это поисковая система, которая ищет в Интернете новую информацию, анализирует ссылки и находит новый контент, который может послужить ответом на вопросы пользователя. В поисковых системах есть специальные роботы, называемые поисковыми роботами или пауками, которые отвечают за ползание по сайту.

p, blockquote 33,0,0,0,0 —>

Поисковые роботы — это программы, которые автоматически посещают веб-сайты и собирают с них информацию. Сканирование может быть первичным (робот впервые попадает на новое место). После первичного сбора информации о сайте и включения ее в базу данных поисковой системы, робот начинает посещать сайты с определенной регулярностью. Если были внесены изменения (добавление нового контента, удаление старого), то все эти изменения фиксируются поисковой системой.

p, blockquote 34,0,0,0,0 —>

Основная задача поискового паука — найти новую информацию и передать ее поисковой системе для следующего этапа обработки, то есть индексации.

p, blockquote 35,0,0,0,0 —>

Индексирование

Поисковая система может искать информацию только на тех сайтах, которые уже находятся в ее базе данных (проиндексированы ею). Если сканирование — это процесс поиска и сбора информации о конкретном сайте, то индексирование — это процесс внесения этой информации в базу данных поисковой системы. На этом этапе поисковая система автоматически решает, включать или не включать ту или иную информацию в свою базу данных, где ее разместить и в какой части базы данных. Google, например, индексирует почти всю информацию, которую его роботы находят в Интернете, в то время как Яндекс более сложен и не индексирует почти все.

p, blockquote 36,0,0,0,0 —>

Для новых сайтов этап индексации может занять много времени, поэтому посетители поисковых систем могут долго ждать новых сайтов. Однако новая информация, появляющаяся на старых, перенаправленных сайтах, может быть проиндексирована почти сразу и добавлена в «индекс», то есть в базы данных поисковых систем, практически мгновенно.

p, blockquote 37,0,0,0,0 —>

После ввода поискового запроса в поисковую строку система проверяет страницы в индексе, чтобы убедиться, что они соответствуют поисковому запросу. Эти страницы оцениваются на основе алгоритма, состоящего из сотен сигналов ранжирования.

Основные функции поисковой системы

Все существующие поисковые системы предназначены для выполнения нескольких важных функций: Поиск информации, индексирование, оценка качества, правильное ранжирование и размещение в поисковых системах. Основная цель любой поисковой системы — предоставить пользователю информацию, которую он ищет, с наиболее точным ответом на конкретный запрос.

Поскольку большинство пользователей не имеют представления о том, как работают поисковые системы в Интернете, а способов научить пользователей «правильно» искать (например, с помощью поисковых подсказок) очень мало, разработчики вынуждены совершенствовать сам поиск. Последняя заключается в разработке алгоритмов и принципов работы поисковых систем, позволяющих им находить нужную информацию, независимо от того, насколько «правильно» сформулирован поисковый запрос.

Сканирование

Он отслеживает изменения в уже проиндексированных документах и ищет новые страницы, которые могут быть отображены в результатах поиска по запросам пользователей. Сканирование веб-ресурсов производится поисковыми системами с помощью специального программного обеспечения, называемого пауками или поисковыми краулерами.

Веб-ресурсы сканируются, и данные автоматически собираются поисковыми ботами. После первого посещения сайта и включения его в поисковую базу данных боты регулярно посещают сайт, отслеживая и регистрируя изменения в его содержимом.

Поскольку количество растущих ресурсов в Интернете велико и новые сайты появляются каждый день, описанный процесс не прекращается ни на минуту. Этот принцип работы поисковых систем Интернета позволяет им всегда иметь актуальную информацию об имеющихся в Интернете страницах и их содержании.

Основная задача поискового робота — находить новые данные и отправлять их в поисковую систему для дальнейшей обработки.

Индексирование

Поисковая система способна находить данные только на тех сайтах, которые находятся в ее базе данных, то есть проиндексированы. На этом этапе поисковая система должна решить, следует ли включить найденную информацию в базу данных и, если да, то в какой раздел. Этот процесс также выполняется автоматически.

Предполагается, что Google индексирует почти всю информацию, доступную в Интернете, в то время как Яндекс более избирателен и не так быстро индексирует контент. Оба поисковых гиганта работают на благо пользователя, но общие принципы работы поисковых систем Google и Яндекс несколько отличаются, так как в их основе лежит уникальная, составная система программных решений.

Поисковые системы объединяет то, что индексирование всех новых ресурсов занимает больше времени, чем индексирование нового контента на сайтах, известных системе. Информация, появляющаяся на сайтах, которые поисковые системы считают особенно надежными, индексируется практически сразу.

Ранжирование

Ранжирование — это оценка алгоритмами поисковых систем релевантности проиндексированных данных и их соответствия факторам, значимым для конкретной поисковой системы. Полученная информация обрабатывается для создания результатов поиска по всему спектру пользовательских запросов. Способ представления информации выше и ниже результатов поиска полностью зависит от того, как работает выбранная поисковая система и ее алгоритмы.

Человек как помощник в борьбе за качество выдачи

Реальность такова, что даже самые продвинутые поисковые системы, такие как Яндекс и Google, по-прежнему нуждаются в помощи человека, чтобы выдавать результаты, соответствующие приемлемым стандартам качества. Если поисковый алгоритм работает недостаточно хорошо, результаты корректируются вручную, оценивая содержание страницы по ряду критериев.

Большая армия специально обученных людей из разных стран — референты поисковых систем — ежедневно проделывают огромный объем работы, чтобы проверить, отвечают ли сайты на запросы пользователей, отфильтровать спам и запрещенный контент (текст, изображения, видео). Работа оценщиков позволяет получить более чистые результаты и способствует дальнейшему развитию самообучающихся поисковых алгоритмов.

Заключение

По мере развития Интернета и постепенного изменения стандартов и форм представления контента меняется и подход к поиску: совершенствуются процедуры индексирования и ранжирования информации, используемые алгоритмы, появляются новые факторы ранжирования. Все эти факторы позволяют поисковым системам выдавать наилучшие результаты, отвечающие потребностям пользователей, но усложняют жизнь веб-мастерам и специалистам, занимающимся продвижением сайтов.

В комментариях под статьей предлагается поговорить о том, какая из основных поисковых систем Рунета — Яндекс или Google, на ваш взгляд, работает лучше, предоставляя пользователю более качественный поиск, и почему.

Чтобы сайт появился в топ-5 поисковых систем, необходимо оптимизировать его для поисковых систем, используя процесс, называемый поисковой оптимизацией или SEO.

Принципы работы поисковой системы

Наиболее важными этапами создания базы данных для поисковых систем являются индексирование и ранжирование веб-сайтов. А для того, чтобы конечные результаты были точными, внедрена система машинного обучения. Это означает, что поисковая система показывает два противоположных результата для сравнения и указывает, какую систему она должна использовать для ранжирования. Таким образом, система знает, какая страница является «полезной», а какая — «менее полезной».

Все это позволяет выделить отдельный показатель — релевантность (условно его можно назвать «ранжирование»). Он присваивается каждому сайту и отображается в виде дроби. Чем выше релевантность, тем выше позиция ресурса в выдаче по поисковому запросу пользователя. Это основные принципы работы поисковых систем, используемых сегодня. И этот процесс также состоит из нескольких этапов.

Сбор данных

После создания сайта и получения ссылок система автоматически анализирует его с помощью инструментов Spyder и Crawling. Информация собирается и упорядочивается на каждой странице.

Индексация

Индексация производится с определенной регулярностью. После этого сайт включается в общий каталог поисковой системы. Результатом этого процесса является индексный файл, который используется для быстрого поиска нужной информации о ресурсе.

Обработка информации

Система получает запрос пользователя и анализирует его. Он определяет ключевые слова, которые используются для поиска в индексном файле. Из базы данных извлекаются все документы, похожие на запрос пользователя.

Ранжирование

Создается список всех документов, выбранных для поиска, каждый из которых имеет свое местоположение. Это делается на основе ранее рассчитанных индексов релевантности.

На этом этапе принцип работы поисковых систем несколько иной. Формула ранжирования также уникальна. Однако наиболее важными факторами, влияющими на релевантность сайта, являются

- Реферальный индекс (как часто сторонние источники ссылаются на информацию на конкретной странице),

- авторитетность домена (определяется по истории изменений),

- релевантность текстовой информации по требованию,

- релевантность другого контента, представленного на странице,

- качество оптимизации веб-сайта.

СОВЕТ! Если вам необходимо поисковое продвижение сайта, я могу помочь вам провести качественный SEO-аудит сайта и составить план продвижения.

Основные характеристики поисковых систем

Наиболее важным параметром является видимость. То есть, насколько точной будет информация, представленная в выводе, остается на усмотрение пользователя, сделавшего запрос. Но есть и другие характеристики для оценки поисковыми системами.

Полнота

Традиционный параметр, указывающий на соотношение между общим количеством документов, созданных в ответ на запрос пользователя, и количеством документов, отображенных системой в результатах. Чем выше значение, тем полнее анализ, проведенный службой.

Точность

Это можно объяснить на примере. Пользователь ввел запрос «купить квартиру». На выходе было представлено 1000 мест. Но в половине случаев встречается только это сочетание слов. Другая часть предлагает ресурсы для покупки недвижимости. Естественно, пользователь заинтересован в последнем. В этом случае точность поисковой службы составляет 0,5 (т.е. 50%). Чем выше число, тем выше точность.

Актуальность

Он относится ко времени между публикацией данных на сайте и их включением в список индексации. Чем быстрее завершается этот процесс, тем больше релевантной информации представляется пользователю в индексе. Для современных сервисов, таких как Bing или Google, база данных индексов обновляется с интервалом до 3 месяцев. Для релевантных сайтов — несколько дней.

Скорость поиска

Это также — «сопротивление нагрузки». Он определяется временем, которое требуется для создания списка сайтов для доставки после получения запроса пользователя. По сути, он зависит только от производительности серверов, обрабатывающих данные, и общего количества полученных запросов. Современные сервисы могут обрабатывать до 100 миллионов таких запросов в секунду.

Наглядность

Оценка работы сервиса пользователями. Это во многом зависит от того, какие ссылки среднестатистический пользователь видит в верхней части результатов. В конце концов, именно их он изучает в первую очередь. И информация, полученная от них, должна на 100% отвечать на его вопросы.

Выводы

Постоянное индексирование и ранжирование — таков основной принцип работы поисковых систем Интернета. И тысячи программистов отвечают за написание алгоритмов и программ, которые выполняют большую часть этой работы. Благодаря их работе каждый пользователь сегодня может найти нужную ему информацию в интернете за считанные секунды.

Если вам понравилась эта статья, поделитесь ею в социальных сетях. Также рекомендуем прочитать статью — как продвигать сайт в интернете.

Если вы хотите лучше понять принцип работы поисковых систем, рекомендую посмотреть видео Сергея Кокшарова и почитать его блог о SEO